Sind wir die Nutzer ‒ oder das Produkt?

Ob Online-Shopping oder TikTok - Empfehlungssysteme prägen unser Verhalten und schlagen passende Produkte vor. Das Buch How Data Happened von Chris Wiggins und Matthew L. Jones beleuchtet die Rolle von Daten in der modernen Welt. Dieser Blogpost fasst die Kernaussagen des Kapitels The Battle for Data Ethics zusammen und ergänzt sie mit Erkenntnissen aus Nicole Lemkes Vortrag zur Frage, wie eine demokratische Gesellschaft mit Daten umgehen sollte.

Historischer Kontext: Die Wurzeln der Forschungsethik

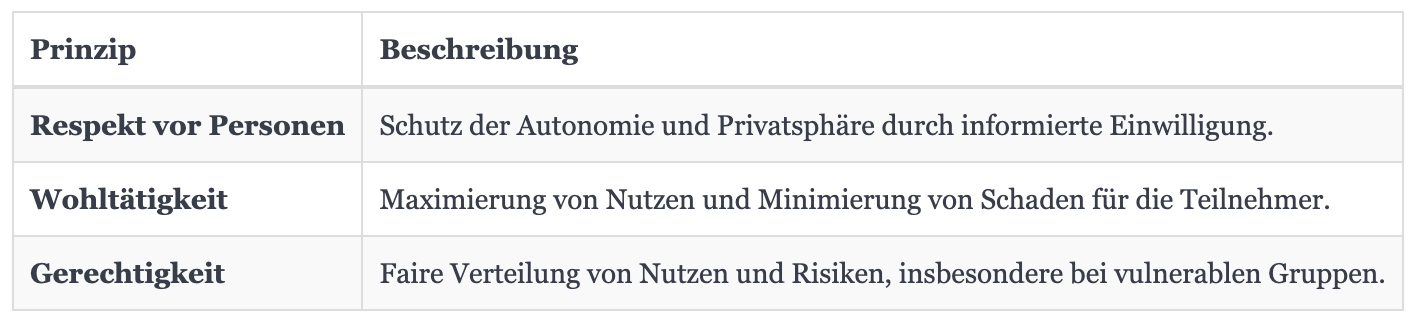

Die Grundlagen moderner Forschungsethik entstanden als Reaktion auf Skandale wie die Tuskegee Syphilis Studie (1932–1972). In Alabama wurden 600 afroamerikanische Männer, von denen 399 an Syphilis litten, ohne informierte Einwilligung untersucht. Selbst als Penicillin in den 1940er Jahren verfügbar war, erhielten sie keine Behandlung. Die Enthüllung 1972 löste Empörung aus und führte zum National Research Act von 1974 sowie dem Belmont Report von 1978, der als Grundlage für die ethischen Regeln und Richtlinien dient, die die Forschung an Menschen regeln. Dieser Report definierte drei ethische Prinzipien:

Diese Prinzipien wurden durch Institutional Review Boards (IRBs) umgesetzt, die Forschungsprojekte prüfen. Doch in der Tech Industrie fehlt es an ähnlich wirksamen Kontrollen, wie Wiggins und Jones betonen.

Datenethik in der Tech Industrie: Herausforderungen und Scheitern

Die Übertragung ethischer Prinzipien auf Algorithmen und KI ist schwierig. Unternehmen wie Meta und Google haben Kontrollgremien eingeführt, die jedoch Probleme aufweisen. Meta's Oversight Board (2018) bearbeitet nur einen Bruchteil der Fälle und wird wegen mangelnder Transparenz kritisiert. Googles Advisory Council (2019) scheiterte nach einer Woche aufgrund interner Proteste. Solche Initiativen werden oft als "Ethics Washing" bezeichnet, da Unternehmen ethisches Handeln suggerieren, ohne echte Verantwortung zu übernehmen - oft zugunsten finanzieller Anreize und Machtstrukturen.

Technische Lösungen: Chancen und Grenzen

Zur Verbesserung des Datenschutzes wurden Methoden wie k-Anonymität und Differential Privacy entwickelt. k-Anonymität erschwert die Identifizierung einer Person, indem ähnliche Merkmale in Gruppen zusammengefasst werden. Differential Privacy fügt absichtlich kleine Fehler in die Daten ein, um die Privatsphäre zu schützen. Diese Techniken stossen jedoch an ihre Grenzen, wenn es um komplexe gesellschaftliche Themen wie Diskriminierung und Verantwortung für algorithmische Entscheidungen geht. Hier kommt das Konzept der Datenjustiz ins Spiel, das weiterführende Fragen aufwirft, wie: Sollten bestimmte Algorithmen überhaupt eingesetzt werden? Wer entscheidet über ihre Anwendung?

Algorithmische Fairness ist ebenfalls eine Herausforderung. Definitionen wie gleiche Ergebnisse für alle Gruppen oder gleiche Chancen auf positive Ergebnisse sind oft nicht vereinbar. Technische Lösungen allein können strukturelle Ungleichheiten und unbewusste Vorurteile in den Daten nicht beheben. Algorithmen verstärken häufig bestehende Diskriminierungen, weshalb eine breitere gesellschaftliche Auseinandersetzung notwendig ist, um diese Ungleichheiten zu bekämpfen.

Demokratische Datenverwaltung: Erkenntnisse aus der KI-Politik

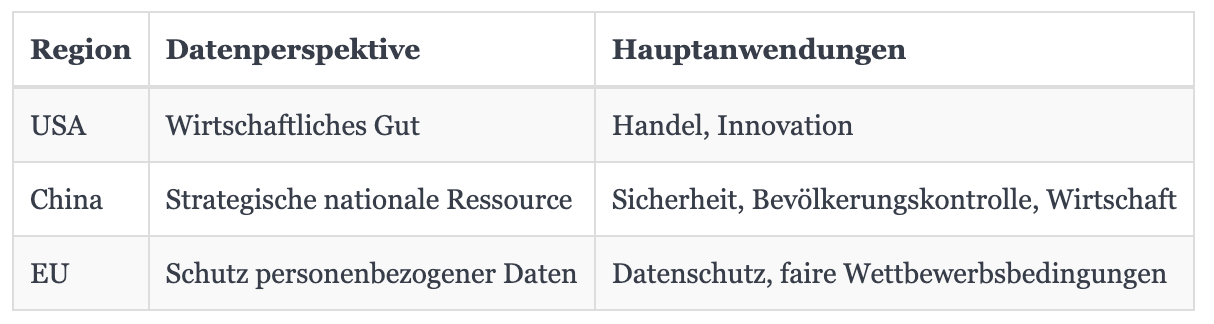

Nicole Lemke, Senior Policy Researcher beim Think Tank interface, betonte in ihrem Vortrag, dass Daten ein gesellschaftliches Thema sind. Weltweit gibt es unterschiedliche Perspektiven:

Lemke wies auf mehrere ethische Probleme hin wie die Nutzung von LinkedIn Privatnachrichten für das Training von KI, obwohl die Nutzerdaten dafür einfach entnommen wurden, ohne dass Nutzer jemals ihre Zustimmung gegeben hätten. Ein weiteres Beispiel ist ein KI-generiertes Bild im Stil der Studio Ghibli Ästhetik, das eine verurteilte Person zeigte und in sozialen Medien Empörung auslöste. Dabei wurde nicht nur ein sensibler Inhalt generiert, sondern auch ein künstlerischer Stil verwendet, dessen Schöpfer, Hayao Miyazaki, sich wiederholt und deutlich gegen den Einsatz von KI in der Kunst ausgesprochen hat. Auch die Arbeitsbedingungen von Datenarbeitern, etwa in Kenia, seien problematisch, da sie häufig unter prekären Umständen sensible Inhalte sichten. Solche Tätigkeiten werden oft an Menschen in Niedriglohnländern ausgelagert, um Kosten zu sparen - teilweise werden dabei Daten unter Missachtung geltender Datenschutzgesetze ins Ausland übertragen.

Eigene Einordnung und Fazit: Wir sind das Produkt

Mich hat beeindruckt, wie historische Fälle wie Tuskegee bis heute nachwirken und wie wenig die Tech-Industrie daraus gelernt hat. Nachdenklich macht mich, dass Algorithmen oft ohne unabhängige Kontrolle arbeiten und dass hinter KI oft Menschen unter unfairen Bedingungen arbeiten, wie Lemke betont. Entscheidend ist, die Datenkompetenz in der Gesellschaft zu stärken, damit Bürger ihre Rechte kennen und an Debatten teilnehmen können. Besonders aktuell finde ich die Diskussion um ChatGPT oder Suchmaschinen, die Inhalte und Bilddaten nutzen, ohne dass Urheber Anerkennung oder Einnahmen erhalten. Oft sind wir als Nutzer das „Produkt" - unsere Daten werden gesammelt und genutzt, meist ohne unser Wissen, während auf dieser Basis KI-Produkte entwickelt werden. Das Kapitel zeigt, dass Datenethik nicht nur Technik betrifft, sondern auch Fragen von Macht, Gerechtigkeit und Verantwortung. Technische Ansätze wie Differential Privacy reichen nicht aus, wenn strukturelle Ungleichheiten unberührt bleiben. Ohne gesellschaftliche Kontrolle können Algorithmen Ungleichheiten sogar verstärken. Wiggins, Jones und Lemke betonen die Bedeutung von Datenkompetenz und globaler Zusammenarbeit. Letztlich bleibt die Frage, ob Ethik und Innovation vereinbar sind - oder ob wir neue Ansätze brauchen, um Technologie fair und im Einklang mit Grundrechten zu gestalten.

Was denkt ihr?

Welche Verantwortung tragen Unternehmen im Umgang mit unseren Daten? Wie können wir als Gesellschaft sicherstellen, dass Technologie und Ethik im Einklang stehen? Schreibt mir eure Meinung!

Weiterführende Ressourcen

- Organisation: Data Justice Lab für Forschung zu Datenjustiz.

- Bericht: EU AI Continent Action Plan für Europas KI-Strategie.

- Artikel: Ein spannender Medium Post von Ajay Pundhir, der das Thema Data Ethics noch näher bringt.